Deepfake, ou mídia sintética, como descreve o CEO da Beyond Layer 7, Matthew Canham, são tecnologias bastante perigosas, utilizadas por cibercriminosos para realizar ataques de engenharia social direcionados, cada vez mais realistas. Caso usadas para o mal, essas tecnologias podem ser devastadoras, principalmente por não estarem no escopo de proteção oferecido pelas soluções de segurança da informação.

Em agosto de 2019, cibercriminosos utilizaram softwares de inteligência artificial para criar um áudio falso de um dos diretores de uma empresa de energia não identificada. Neste áudio, encaminhado a um profissional do financeiro dessa empresa, os cibercriminosos disfarçados pediram uma transferência de € 220 mil (R$ 1,3 milhão), que foi feita sem muitos questionamentos, já que o funcionário reconheceu a voz do diretor e pedidos como esse faziam parte da rotina da empresa. Este ficou conhecido como um dos grandes casos de ciberataques com uso de ferramentas de deepfake.

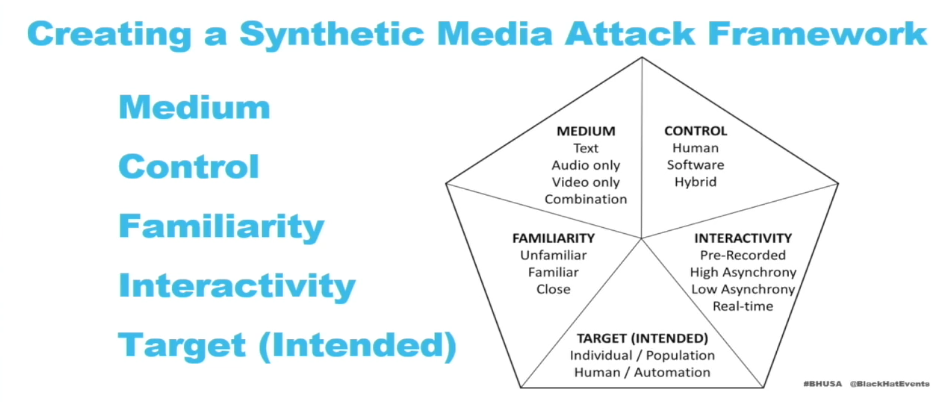

O pesquisador Matthew Canham, é criador de um framework para investigação de ataques que utilizam tecnologia deepfake, tanto de imagem como voz. Em uma apresentação nesta quinta-feira (05), durante o Black Hat USA 2021, Canham detalhou seu framework e deu dicas valiosas às empresas de segurança, de como utilizar este framework para detectar ataques de engenharia social, que utilizam essas tecnologias maliciosas.

Canham pesquisa estes ataques há pelo menos cinco anos. Seus principais interesses são entender como seres humanos podem estar vulneráveis a esses ataques. Ele conta que quando começou a estudar esses casos, os ataques eram quase idênticos: robôs configurados para telefonar para vítimas pedindo que comprassem cartões presentes, quando a vítima interagia com os robôs um ser humano assumia o comando e “uma dramática mudança de tom de voz” era observada.

O framework

Seu esquema de identificação de deepfake em ataques cibernéticos contempla cinco pontos iniciais:

- Meio: texto, áudio, vídeo ou uma combinação dos três;

- Interatividade: uma gravação ou apresentação em tempo real;

- Controle: por um ser humano, por um software (robô) ou híbrido;

- Alvo: um ser humano, uma empresa ou um grupo de pessoas;

- Familiaridade: se o alvo é desconhecido, um integrante da família ou alguém próximo do atacante.

Deepfake permite que cibercriminosos personifiquem um amigo, conhecido ou até um membro da família, o que permite uma infinidade de abordagens criminosas. Um exemplo é o “sequestro virtual”, onde um atacante forja áudios e vídeos de uma vítima, entra em contato com a família dela e diz ter a sequestrado e claro, pede um valor pelo resgate dessa vítima, que na realidade não foi sequestrada.

Outro exemplo é utilizar essas tecnologias para criar perfis falsos em redes sociais e sites de relacionamento e com isso enganar vítimas para campanhas tão amplas quanto a criatividade de quem as opera. Canham espera que esse framework ajude, não apenas os profissionais de segurança, mas a qualquer pessoa a identificar ataques que utilizam texto, áudio e vídeo falsos, criados

FONTE: THE HACK